Googlen tekoäly nielee Tilastokeskuksen liikennettä – virasto lyö takaisin kehittämällä oman tekoälyavustajan

Tilastokeskus kehittää tietokanta-avustajan torjuakseen epätarkkuuksia, kun Googlen tekoälytiivistelmät aiheuttavat 17 prosentin pudotuksen verkkosivustovierailuissa. Ongelma johtuu siitä, miten tekoälyjärjestelmät hakevat tietoa.

Teksti: Martti Asikainen, 2.12.2025 | Kuva: Adobe Stock Photos

Tilastokeskus on käynnistänyt aloitteen kasvavan ongelman ratkaisemiseksi. Tilastokeskuksen mukaan tekoäly antaa epätarkkaa tietoa tilastollisesta datasta, joka syö viraston sivustoliikennettä.

Tilastokeskus raportoi jopa 17 prosentin laskusta verkkosivustovierailuissa Google-hakujen kautta tämän vuoden ensimmäisen 11 kuukauden aikana verrattuna viime vuoden vastaavaan ajanjaksoon. Viraston mukaan pudotus johtuu Googlen tekoälyn luomista hakutiivistelmistä, jotka estävät käyttäjiä etsimästä tarkempaa tietoa.

Tilastokeskuksen pääjohtaja Ville Vertasen mukaan he ovat huomanneet, että tekoälyllä vahvistettujen hakuavustajien antamat tiedot tilastoista ovat usein virheellisiä. Tämä johtuu siitä, miten tekoälyt hakevat tietoa.

– Se merkki siitä, että osa tietoa hakevista henkilöistä tyytyy tekoälytiivistelmään, eikä hakeudu tarkemman tilastotiedon äärelle. Sen sijaan että Googlen tekoäly käyttäisi suoraan tilastotietokantojamme, se kokoaa vastaukset aiemmin Tilastokeskuksen verkkosivustolta tai muualta haetuista tiedoista, hän totesi Ylelle.

Vertasen mukaan menetelmä voi johtaa vanhentuneen tai epätarkan tiedon tarjoamiseen käyttäjille, jotka tarvitsevat ajankohtaista dataa yhteiskunnallisesta ilmiöstä tai muusta vastaavasta..

Kyse on maailmanlaajuisesta ongelmasta

Vertanen kertoi Yle Uutisille, että ongelma ulottuu Suomen rajojen ulkopuolelle. Tekoälyongelmat ovat nousseet kuumaksi puheenaiheeksi tilastotieteilijöiden keskuudessa maailmanlaajuisesti.

Huoli on monella tapaa perusteltu. European Broadcasting Unionin koordinoima ja BBC:n johtama tuore tutkimus paljasti, että 45 prosentissa tekoälyavustajien vastauksista oli vähintään yksi merkittävä ongelma. Näitä olivat muun muassa keksityt yksityiskohdat ja vanhentunut tieto.

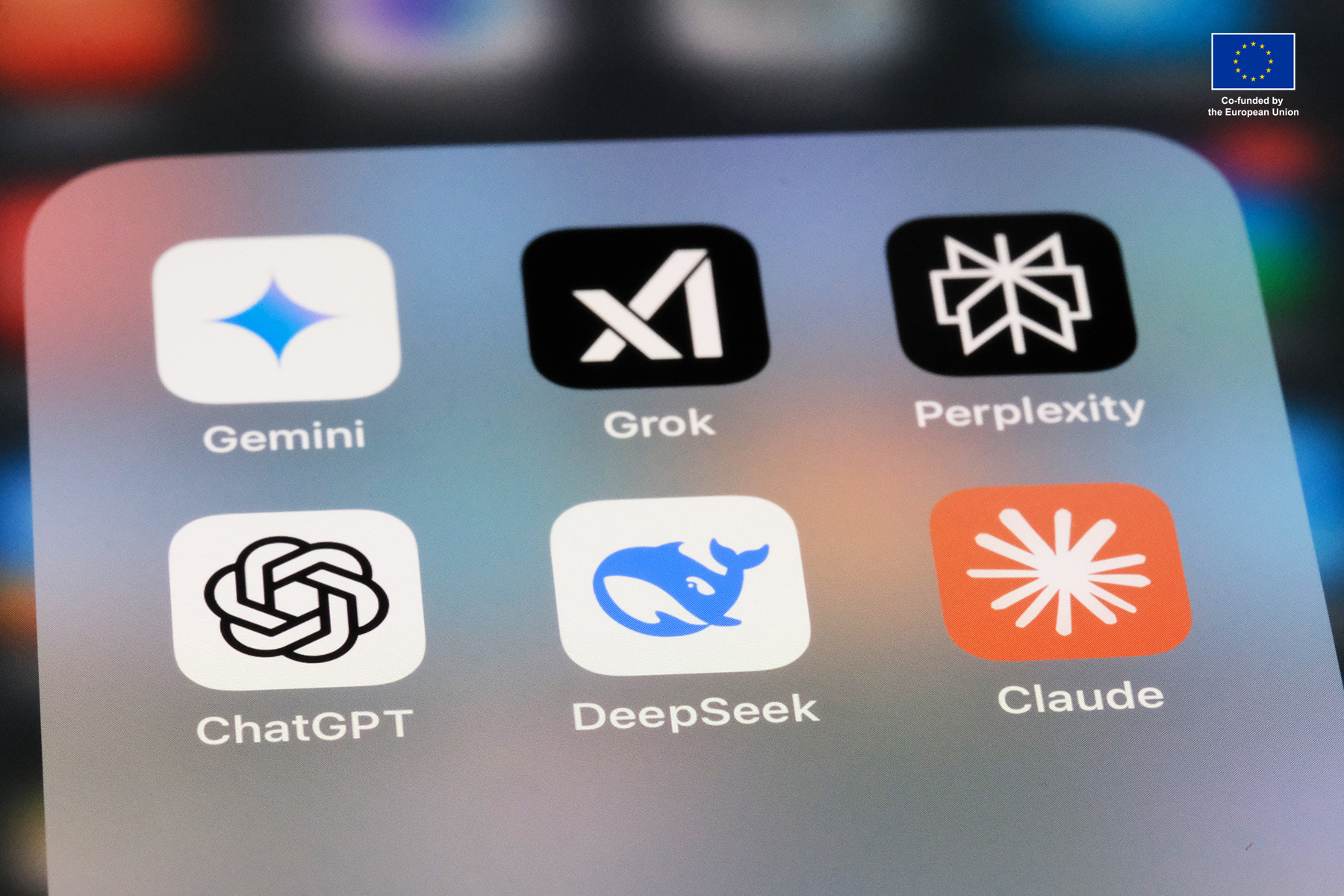

Kansainväliseen tutkimukseen osallistui yhteensä 22 julkisen palvelun mediaorganisaatiota 18 maasta. Tutkimus tehtiin 14 kielellä, ja siinä arvioitiin yli 3 000 vastausta ChatGPT:ltä, Copilotilta, Geminiltä ja Perplexityltä.

Ammattitoimittajat arvioivat vastaukset keskeisten kriteerien, kuten tarkkuuden, lähdeviitteiden ja kontekstin perusteella. Tulokset olivat huolestuttavia. Jopa 31 prosentissa vastauksista oli vakavia lähdeongelmia, kuten puuttuvia, harhaanjohtavia tai virheellisiä viittauksia. Noin 20 prosentissa oli suuria tarkkuusongelmia.

Tilastokeskus rakentaa tekoälytulkin

Haasteiden ratkaisemiseksi Tilastokeskus on päättänyt kehittää sitä, mitä Vertanen kutsuu tietokantojensa tulkiksi. Kyse on järjestelmästä, joka opettaa tekoälyn lukemaan tilastoja oikein.

Ehdotettu ratkaisu käyttää Model Context Protocol -protokollaa, joka yhdistää tekoälysovellukset ulkoisiin järjestelmiin, kuten tilastotietokantoihin. Se on avoin standardi, jonka avulla kehittäjät voivat rakentaa turvallisia, kaksisuuntaisia yhteyksiä tietolähteidensä ja tekoälypohjaisten työkalujensa välille.

Tällä tekniikalla tekoäly voisi etsiä tietokannasta vastauksia kysymyksiin kuten ”miten inflaatio on kehittynyt Suomessa viimeisen kolmen vuoden aikana?”. Se hakisi tiedon suoraan auktorisoiduista lähteistä sen sijaan, että luottaisi mahdollisesti vanhentuneeseen verkkosisältöön.

Tilastokeskus tunnistaa, että sen tietokanta on valtava, ja koko tekee tiedon löytämisestä haastavaa. Vertanen kertoi Yle Uutisille, että suunnitteilla oleva tietokanta-avustaja helpottaisi oikean datan löytämistä kaikille. Esimerkkeinään hän mainitsee virkamiehet, kansalaiset, toimittajat ja tutkijat.

Tilastokeskus aikoo käynnistää pilottiohjelman jo ensi vuonna.

Miksi tekoäly ymmärtää tilastot väärin

Perusongelma vääristyneessä tiedossa piilee siinä, miten tekoälyjärjestelmät toimivat. Suuret kielimallit ennustavat seuraavan sanan ketjussa puhtaasti tilastollisen laskennan perusteella. Tämä saa ne näyttämään sujuvilta, mutta tekee niistä samalla alttiita keksimään asioita. Niillä ei ole luontaista perustaa, johon nojata.

Tutkimus on osoittanut, että Googlen AI Overview toistaa usein vanhentuneita vastauksia yksinkertaisesti siksi, että ne edustavat yleisintä verkosta löytyvää versiota. Kyseinen järjestelmä nojaa vahvasti yksimielisyyteen tarkkuuden sijaan. Tämä tarkoittaa, että suosittu mutta virheellinen tieto voi syrjäyttää uudemmat, oikeat vastaukset.

Google väittää, että sen testit osoittivat AI Overviews -toiminnon tarkkuusasteen olevan samalla tasolla kuin featured snippets -otsikoiden. Epätarkkaa tietoa esitetään vain pienessä osassa tapauksia.

Kriitikot ovat kuitenkin sitä mieltä, että pienetkin prosenttiosuudet voivat olla merkittäviä riskejä, kun miljoonat luottavat näihin tiivistelmiin saadakseen tietoa.

Luottamus ja sen seuraukset

Virheellisen tiedon seuraukset ulottuvat myös epämukavien tilastojen ulkopuolelle. Reuters Instituten Digital News Report 2025 -raportin mukaan seitsemän prosenttia kaikista verkossa uutisia seuraavista kuluttajista käyttää tekoälyavustajia uutisten saamiseen. Alle 25-vuotiaiden keskuudessa osuus nousee 15 prosenttiin.

– Tämä tutkimus osoittaa lopullisesti sen, että nämä puutteet eivät suinkaan ole yksittäisiä tapauksia, vaan systeemisiä, rajat ylittäviä ja monikielisiä. Uskomme, että tämä voi vaarantaa yleisön luottamuksen, totesi EBU:n mediajohtaja Jean Philip De Tender.

BBC:n johtama EBU-tutkimus myös paljasti, että tekoälyavustajat vääristelevät rutiininomaisesti uutissisältöä riippumatta siitä, mitä kieltä, aluetta tai tekoälyalustaa testataan.

Tässä valossa tarkasteltuna Tilastokeskuksen aloite edustaa laajempaa pyrkimystä datantarjoajien ja uutisorganisaatioiden keskuudessa. Tavoitteena on varmistaa, että tekoälyjärjestelmät käyttävät auktorisoitua tietoa suoraan sen sijaan, että ne luottaisivat mahdollisesti virheellisiin kokoelmiin.

Jää nähtäväksi, voiko tämä lähestymistapa skaalautua ratkaisemaan laajemman tekoälyn epätarkkuusongelman.

Finnish AI Region

2022-2025.

Media contacts